Local PC에 LLM 설치하기

설치 준비

- PC 사양 : GPU nvidia 30* 이상

- nvidia-smi 명령으로 드라이버 설치 상태 확인

- Disk 빈공간 10GB 이상 추천

- 설치파일 다운로드

- ollama windows : https://ollama.com/download

- chat box : https://chatboxai.app/en?c=download-windows

ollama 설치

- 준비된 OllamaSetup.exe 실행으로 설치

- 터미널 실행 (시작 메뉴 우클릭) 후 아래 명령 순차적으로 입력

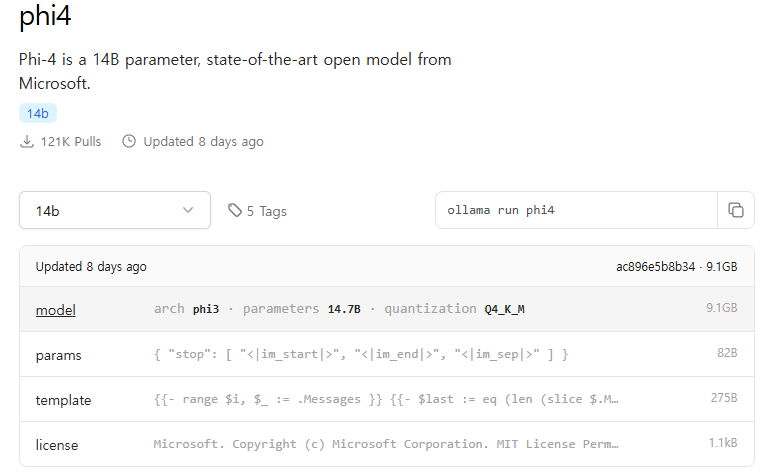

ollama run phi4

/byechatbox 설치

- 준비된 chatbox setup 파일 실행

- 설치 완료 후 아래와 같이 설정

- Ollama 실행 중인 주소 중요! 기본값 : localhost:11434

사용하기

대화하기

- 새로운 채팅 클릭 후, 모델 선택 후 대화 시작

새로운 모델 적용

- https://ollama.com/search 에서 각종 모델 검색 가능

- 모델 선택 후 모델의 크기와 로컬 GPU의 VRAM 크기를 염두에 두고 선택

- 터미널 환경에서 Pull 실행

ollama pull 설치하고자하는모델명Trouble Shooting

- [chatbox] 리스트에 모델이 잡히지 않는다면 터미널에서 “ollama serve” 실행 - 이미 실행중이라면 포트 사용 중 메시지가 뜸

- [chatbox] 새 채팅 시작! - phi4 혹은 exaone3.5 이용 가능 (리스트에 나오지 않는다면 설정에서 추가)